NovoNotes 3DXを立体音響制作のツールとして”基準”となる製品だと言ってきました。

それはどういうことでしょうか?

それはどういうことでしょうか?

UIを見てわかるように簡単そうなので”基準”に出来そう、というのも一つの答えですが、ここではちょっと深く解説したいと思います。

3DXは、3Dパンナー、Ambisonicsエンコード&デコード、バイノーラルプロセッシング、の3本柱で構成されたプラグインです。

(本当はここに残響が加わると完全なのですが、残響は複雑で難しい)

3DXはプラグインです。

挿したらすぐに音が出て欲しいです。

まず、何か作ろうとしたとき、やはり直観的に扱いたいもの。

立体音響のツールは何故か小難しく、音が出るまでに時間が掛かるものが多いです。

音が出たとしても、これで正しい設定なのだろうか?となってしまいます。

簡単に音が出て、触ったら素直に反応する、それは”基準”となるための最初の一歩だと思います。

さて、個別に解説しましょう

3Dパンナー

3Dパンニングの”基準”とは何でしょうか?

パンナーというと音を動かすイメージがあるかも知れませんが、音を定位させることがまずあります。

パンナーというと音を動かすイメージがあるかも知れませんが、音を定位させることがまずあります。

左90度にパラメーターで指定したら、左90度に音像が生まれる。

任意の位置に音が定位するのは”基準”としての基本条件です。

スピーカー配置が、4chスクエア、5ch、7.1.4ch、8chキューブ、いかなるフォーマットにおいても。

任意の位置に音が定位するのは”基準”としての基本条件です。

スピーカー配置が、4chスクエア、5ch、7.1.4ch、8chキューブ、いかなるフォーマットにおいても。

しかしツールによってはそれが”条件付き”での実現であったりします。

どういうことでしょうか?

どういうことでしょうか?

Cycling ’74 Max を使っている人にとって、立体音響と言えばIrcam Spatです。

その豊富なパラメーターをMax上で自在に組み合わせ立体音響システムを構築できるのは素晴らしいですが、使いこなすにはかなりの知識が必要です。

音のシミュレーションプログラムの色が強いので、音楽制作で使うにはそこまで必要のないと思われる機能も備わっています。

それをFLUXが音楽制作でも使えるようにUIを整備したのがSpat Revolutionです。

その豊富なパラメーターをMax上で自在に組み合わせ立体音響システムを構築できるのは素晴らしいですが、使いこなすにはかなりの知識が必要です。

音のシミュレーションプログラムの色が強いので、音楽制作で使うにはそこまで必要のないと思われる機能も備わっています。

それをFLUXが音楽制作でも使えるようにUIを整備したのがSpat Revolutionです。

パラメーターが多いからスゴイというのは安易で、目的に応じてある程度機能をまとめたり、必要なパラメーターを扱いやすく表示させるなどし、シンプルにすることの方が難しくスゴイことです。

3DXのUIが非常にシンプルなのは、立体音場を表現できる最低限必要な機能に絞り、その調整幅を経験則に基づいて無駄無く設計されているからです。

Spat RevolutionlはあのSpatをUIとしてよくまとめていると思います。

ただ、別のアプリをコントロールしていることには変わりないので、その点でどうにもならない扱いにくさはあります。

3DXのUIが非常にシンプルなのは、立体音場を表現できる最低限必要な機能に絞り、その調整幅を経験則に基づいて無駄無く設計されているからです。

Spat RevolutionlはあのSpatをUIとしてよくまとめていると思います。

ただ、別のアプリをコントロールしていることには変わりないので、その点でどうにもならない扱いにくさはあります。

話を定位に戻します。

分かりやすく話すために、8chキューブのスピーカー配置で話を進めます。

Spat Revolutionには基本セットアップに3DXと同じ様に8ch Cubeが含まれています。

すばらしい。

すばらしい。

実はこれ立体音響ツールとしては当然のことで、特にAmbisonicsを扱える立体音響ツールでは基本と言えるスピーカー配置です。

DAWに8chキューブが用意されていないのは、それが音楽制作ツールだからで、立体音響ツールでは無いからです。

立体音響にルーツがあるなら8chキューブは当然あるべき配置なのです。

その8chキューブ配置でSpat Revolutionを設定し、スピーカーエリア中央のリスニング位置に対し方位角-90度、つまり左真横に音を定位させてみましょう。

DAWに8chキューブが用意されていないのは、それが音楽制作ツールだからで、立体音響ツールでは無いからです。

立体音響にルーツがあるなら8chキューブは当然あるべき配置なのです。

その8chキューブ配置でSpat Revolutionを設定し、スピーカーエリア中央のリスニング位置に対し方位角-90度、つまり左真横に音を定位させてみましょう。

Spat Revolution Essential(機能が絞られたバージョン)ではパンニングアルゴリズムを以下の3つから選択出来ます。

VBP Dual-Band:ベクトルベースのパンニング

KNN:K Nearest Neighbourのアンプリチュードパンニング

LBAP:レイヤーベースのアンプリチュードパンニング

さぁ表現したい音にもっとも適したパンニングアルゴリズムを選んでください。

選べないですよね?

それぞれどんなアルゴリズムなのか、マニュアルには書いてありますので興味のある人は確認してください。

それぞれどんなアルゴリズムなのか、マニュアルには書いてありますので興味のある人は確認してください。

しかし知りたいのは仕組みではありません。

実際にどんな音になるのか、です。

これらのパンニングは、その時のスピーカー配置によっても表現が変わります。

それらを知るためにかなり使い込む必要があり、そして使い込むと一長一短であることが分かります。

実際にどんな音になるのか、です。

これらのパンニングは、その時のスピーカー配置によっても表現が変わります。

それらを知るためにかなり使い込む必要があり、そして使い込むと一長一短であることが分かります。

最低限必要な表現力を持ったアルゴリズムを一つだけ提供した方が、ユーザーはそれを”基準”にしやすくなります。

では一つずつ解説します。

VBP Dual-Band

VBPはベクトルベースパンニングの略です。

このベクトルベースのアルゴリズムは、3点から一つの仮想点を計算するアルゴリズムなので、最大3台のスピーカーからの出力で任意の位置に音像をつくります。

このベクトルベースのアルゴリズムは、3点から一つの仮想点を計算するアルゴリズムなので、最大3台のスピーカーからの出力で任意の位置に音像をつくります。

8chキューブ配置のように、下層に4台、上層に4台のスピーカーで6つのスクエアの面を作っている場合、-90度に音を定位させるのであれば、左の下層2台上層2台の4つのスピーカーを同じ音量で鳴らせばその面の中央つまり-90度に音が定位することは想像がつくと思います。

しかしベクトルベースでは最大3台のスピーカーなので、こうなります。

スピーカー#1と#7、対角の2台のファンタムセンターに音を定位。

これはかなり大問題で、リスニングポイントがスピーカーエリアの中央から少しでも外れると定位しなくなるだけでなく、音を動かしていったときのスムースな音像移動の妨げになります。

中央から全く動かないリスニングポイントはヘッドフォンでのバイノーラル再生であれば成立しますが、しかしそれでもすまされない欠点があります。

これはかなり大問題で、リスニングポイントがスピーカーエリアの中央から少しでも外れると定位しなくなるだけでなく、音を動かしていったときのスムースな音像移動の妨げになります。

中央から全く動かないリスニングポイントはヘッドフォンでのバイノーラル再生であれば成立しますが、しかしそれでもすまされない欠点があります。

これは先ほどの位置から仰角を+20度にしたときです。

|

| 3台のスピーカーで方位角-90度仰角+20度を作るSpat |

計算上は、方位角-90度、仰角+20度に定位しているのでしょう。

しかし現実では、#1, #5の方へ音像は引っ張られてしまいます。

上層のスピーカーと下層のスピーカーでは周波数特性は完全に一致することはありません。

なので、片側は上下層、もう片側は上層のみ、と言う明らかなバランスの違いを聴きとれてしまいます。

次は仰角+45度です。

|

| 仰角+45度では上層2台スピーカーでの定位となる |

#5と#7の上層スピーカーが同じ音量で鳴り方位角-90度の軸上へ戻ります。

仮に方位角-90度で下から上に音像を移動させたとしたら、前後に波打ちながら移動することとなります。

実際には作品内でその様な定位に気付くことは難しいです。

だから問題にはならないかも知れませんが、Mixしていく段階では困ることも多いと思います。

実際には作品内でその様な定位に気付くことは難しいです。

だから問題にはならないかも知れませんが、Mixしていく段階では困ることも多いと思います。

Mix時のみならず、例えば様々な広さの空間やスピーカー配置で作品をインストールする人にとって、この様な複雑なアルゴリズムからなる音を現場で修正することは不可能なので扱いにくいです。

またVBPでは、計算が出来ないからだと思いますが、スピーカー配置の中央、つまり座標で言うとx,y,z = 0,0,0は無音になります。

音像=リスナー位置の音は作れないです。

音像=リスナー位置の音は作れないです。

ちなみに7.1.4chなども、上層に4chスクエアがあるので、このパンでTop Center(真上)に定位させると、Top Front LeftとTop Back Rightの2つのスピーカーだけが出力します。

想像出来ると思いますが、真上になど決して定位しません。

LBAPはどうでしょうか?

LBAPなどのアンプリチュードパンニングは#1, #3, #5, #7の4台のスピーカーで中央に音を定位させるのでベクトルベースの様な問題はありません。

よって直観的に扱えます。

よって直観的に扱えます。

LBAPは水平4chがベースになって高さ方向の階層をクロスフェードで行き来しているそうですが、そうとは思えない自然な上下の音像移動を実現しています。

しかし、水平方向に関しては中心を通る時に極端に音がスイッチします。

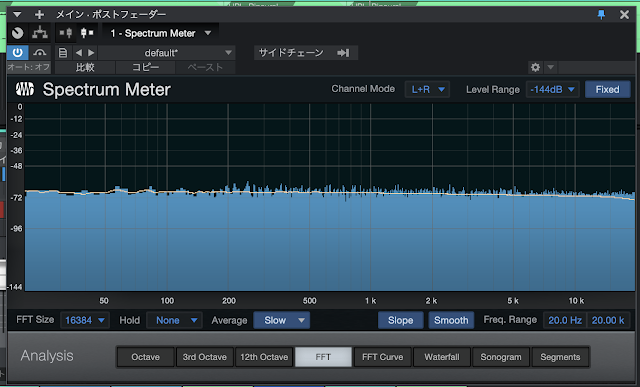

どういうことかと言うと、こちらはスピーカーエリアの中心x,y,z=0,0,0から横軸に極僅か動かした時のレベルメーターです。

|

| x,y,z=0,0,0から方位角-90度方向へ極僅か動かした出力 |

|

| x,y,z=0,0,0から方位角+90度方向へ極僅か動かした出力 |

動画で実際の音像移動を聴いて見ましょう。

HPLで8chキューブをバイノーラル化していますので、ヘッドフォンで視聴してみてください。

この様に上層、下層でも中心を通る時に音がスイッチしてしまいます。

こうした欠点を補うのがKNNです。

KNNではより多くのスピーカーで補間しながら音像移動できるため、スイッチは起きません。

しかし定位は甘くなり、音像を遠くにすることも苦手です。

しかし定位は甘くなり、音像を遠くにすることも苦手です。

また、KNNでも中心x,y,z=0,0,0に音を置くこと、つまり8台すべてのスピーカーが同じ音量で鳴ることはできません。

|

| x,y,z=0,0,0への定位を試みてもどちらかへズレる |

いかがですか?

いずれの問題も設定を調整すると、ある程度問題点を緩和することは出来るのですが、それは使い込んで知ってから出来る調整なので、”基準”となりえる性能とは言えません。

いずれの問題も設定を調整すると、ある程度問題点を緩和することは出来るのですが、それは使い込んで知ってから出来る調整なので、”基準”となりえる性能とは言えません。

今回はSpat Revolutionで検証していますが、他の3Dパンナーも同様のパンニングアルゴリズムが採用され、それをベースに開発されていますので、同じ問題を含んでいる可能性があります。

Spat Revolution Essentialのパンニングアルゴリズムは3つだけですが、上位モデルのSpat Revolutionでは多くの基本パンニングアルゴリズムが備わっていますので、興味のある人は購入して検証してみると面白いです。

Spat Revolutionは音像に対する細かなパラメーターを備えており、かつ残響を伴う表現が可能ですので、音像のシミュレーターとして実力を発揮するツールだと思います。

さて、こちらは3DXのx,y,z=0,0,0です。

|

| 3DXのx,y,z=0,0,0はすべてのスピーカーが同じ出力となる |

すべてのスピーカーの出力レベルが揃います。

普通です。予想通りです。解りやすいです。

実際の音像移動です。

普通です。予想通りです。解りやすいです。

実際の音像移動です。

滑らかです。距離感も出ています。

想像を裏切らない表現です。

”基準”とは作り手が想像する様な結果が得られることではないでしょうか?

ちなみに、空間系パンナーでは無いSony 360RAやAmbisonicsのパンナーは、球面で音を定位あるいは移動できるだけで遠近の操作が出来ないので、3Dパンナーの”基準”にはなりません。

3DXの二つ目の”基準” Ambisonics

3DXの二つ目の”基準” Ambisonics

昔から高次Ambisonicsはありましたが、今の様に実用はされていませんでした。

高次になってAmbiXが主流になる前はFuMaの1次のみです。

高次になってAmbiXが主流になる前はFuMaの1次のみです。

使いみちとしては現在も主流のテトラ型の4chマイク(A-format)を1次Ambisonics(B-format)へ変換し、それをスピーカーデコードして聴くというもの。

2000年ころだったか、当時入手出来たあらゆるAmbisonicsスピーカーデコーディングプラグインを試し、その中でもっとも音質と空間再現性に優れ没入感のあったプラグインの音を基準とし、3DXのスピーカーデコードは開発されています。

どこかで書いたか話したと思いますが、Ambisonicsのスピーカーデコードには様々なアルゴリズムがあり、どれが正しいという定義がありません。

好きな音のものを選んで使う、なのです。

つまり”基準”がありません。

初めてAmbisonicsを聴いた人はそれがそのものと思ってしまうはずですが、そうであるかは分からないのです。

仮にその時のスピーカー配置が7.1.4chであったなら、その音は僕の知るAmbisonicsの音の特長が60%程度の立体音場感でしかありません。

Ambisonicsアルゴリズムでは、スピーカーを前後左右上下に均等配置することが最も正しいデコード結果が得られるので、そのミニマムなシステムとなる8chキューブという存在が立体音響では当たり前と言ったのはこのことです。

3DXは、8chキューブで当時の最も優れたデコーダープラグインと同等の音を生成します。

それが”基準”となります。

立体音響ラボで、いくつかのAmbisonics音源を8chキューブで試聴していますのでヘッドフォンをしてご覧ください。

開始位置 50:30 あたりから

この時はまだ3DXが発売前。

開発途中のAmbisonicsデコーダーが使われています。

最後に

バイノーラルプロセッシングの”基準”についてですが、

これはHPLです。

HPLはヘッドフォン内でスピーカーフォーマットの音場が正しく鳴っている感が最も高いバイノーラルプロセッシングです。

このページのデモ動画はすべてHPLでバイノーラル化しています。

他のバイノーラルプロセッシングとの比較は、前回のブログで書いている通りです。

3Dパンニング、Ambisonics、”基準”を見据えた場合どちらも共通して言えることはシンプルな設計、シンプルなアルゴリズムです。

やはり色々やってしまうとその分音に影響がでます。

HPLもシンプルなバイノーラルプロセッシングであるがゆえに音は素直で、それが例えL/Rスピーカーで再生しても違和感が少ないことにも繋がっています。

何ならアドバンテージとなることも。

テレビの主音声でバイノーラル放送することが許されるバイノーラルプロセッシングは他にはありません。

音を定位させる

音像を移動させる

Ambisonicsを正しくデコードする

正しくバイノーラル化する

何ならアドバンテージとなることも。

テレビの主音声でバイノーラル放送することが許されるバイノーラルプロセッシングは他にはありません。

音を定位させる

音像を移動させる

Ambisonicsを正しくデコードする

正しくバイノーラル化する

NovoNotes 3DXはそれらを備え、且つ誰でもすぐに使えるUIを持った”基準”と成り得るプラグインです。

それを”基準”とすれば、必ず他のツールの良し悪しや有効的な使い方を探ることができます。

立体音響制作には大切なステップです。